Всё, что вам нужно — это внимание

«Attention Is All You Need»[1][2] (с англ. — «Внимание — это всё, что вам нужно») — знаковая[3][4] научная статья 2017 года в области машинного обучения, написанная восемью учёными, работавшими в Google. В статье была представлена новая архитектура глубокого обучения, известная как трансформер, основанная на механизме внимания, предложенном в 2014 году Баданау и др.[5] Она считается фундаментальной[6] работой в современном искусственном интеллекте и одним из основных факторов бума ИИ, поскольку трансформерный подход стал основной архитектурой для широкого спектра ИИ-систем, таких как большие языковые модели[7][8]. На момент публикации основное внимание исследования было сосредоточено на улучшении методов seq2seq для машинного перевода, однако авторы пошли дальше, предвидя потенциал этой техники для других задач, таких как ответы на вопросы и то, что сейчас известно как мультимодальный генеративный ИИ[1].

Название статьи является отсылкой к песне «All You Need Is Love» группы The Beatles[9]. Название «Трансформер» было выбрано потому, что Якобу Ушкорейту, одному из авторов статьи, понравилось звучание этого слова[10].

Ранний проектный документ назывался «Трансформеры: итеративное самовнимание и обработка для различных задач» и включал иллюстрацию шести персонажей из франшизы Трансформеры. Команда получила название «Team Transformer» (Команда Трансформер)[9].

Некоторые из ранних примеров, на которых команда опробовала свою архитектуру Трансформера, включали перевод с английского на немецкий, генерацию статей Википедии на тему «Трансформер» и синтаксический анализ. Это убедило команду в том, что Трансформер является языковой моделью общего назначения, а не только подходящей для перевода[10].

По состоянию на 2025, статья была процитирована более 173 000 раз[11], что ставит её в число десяти наиболее цитируемых статей XXI века[12].

Авторы

Авторами статьи являются: Эшиш Васвани, Ноам Шазир, Ники Пармар, Якоб Ушкорейт, Ллион Джонс, Эйдан Гомес, Лукаш Кайзер и Илья Полосухин. Все восемь авторов внесли «равный вклад» в статью; порядок их перечисления был случайным. Статья в Wired подчёркивает многонациональность группы[9]:

Шестеро из восьми авторов родились за пределами Соединённых Штатов; двое других — это дети немцев с грин-картами, временно находившихся в Калифорнии, и американец в первом поколении, чья семья бежала от преследований, соответственно.

После публикации статьи все авторы покинули Google, чтобы присоединиться к другим компаниям или основать стартапы. Некоторые из них выражали мнение, что не смогли бы развивать и расширять Трансформер в желаемом направлении, если бы остались в Google[13].

Обсуждаемые и представленные методы

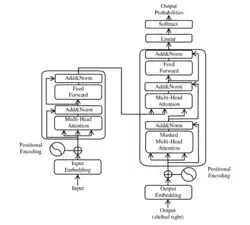

Статья наиболее известна благодаря представлению архитектуры Трансформера, которая лежит в основе большинства современных больших языковых моделей (LLM). Ключевая причина, по которой эта архитектура предпочтительна для большинства современных LLM, — это её распараллеливаемость по сравнению с предшественниками. Это обеспечивает возможность ускорения операций, необходимых для обучения, на GPU, что позволяет сократить время обучения и обучать модели большего размера.

В рамках разработки архитектуры трансформера в статье были представлены следующие механизмы.

Масштабированное скалярное произведение внимания и самовнимание

Использование механизма масштабированного скалярного произведения внимания и самовнимания вместо рекуррентной нейронной сети или долгой краткосрочной памяти (LSTM) (которые основаны на рекурренсии) позволяет достичь лучшей производительности, как описано в следующем параграфе. В статье масштабированное скалярное произведение внимания описывается следующим образом:

где , , — это соответственно матрицы запросов, ключей и значений, а — размерность значений.

Поскольку модель опирается на матрицы запросов (Q), ключей (K) и значений (V), которые происходят из одного и того же источника (т. е. входной последовательности / контекстного окна), это полностью устраняет необходимость в RNN, обеспечивая распараллеливаемость архитектуры. Это отличается от первоначальной формы механизма внимания, представленного в 2014 году. Кроме того, в статье также обсуждается использование дополнительного масштабирующего коэффициента, который, как было установлено, наиболее эффективен по отношению к размерности векторов ключей (обозначенной как и первоначально установленной в 64 в статье), как показано выше.

В конкретном контексте перевода, на котором была сосредоточена статья, матрицы запросов и ключей обычно представляются в виде эмбеддингов, соответствующих исходному языку, в то время как матрица значений соответствует целевому языку.

Многоголовочное внимание

В механизме самовнимания запросы (Q), ключи (K) и значения (V) динамически генерируются для каждой входной последовательности (обычно ограниченной размером контекстного окна), что позволяет модели фокусироваться на разных частях входной последовательности на разных этапах. Многоголовочное внимание улучшает этот процесс, вводя несколько параллельных «голов» внимания. Каждая голова внимания изучает различные линейные проекции матриц Q, K и V. Это позволяет модели одновременно улавливать различные аспекты взаимосвязей между словами в последовательности, а не сосредотачиваться на одном аспекте.

Таким образом, многоголовочное внимание обеспечивает обновление входных эмбеддингов с более разнообразных точек зрения. После вычисления выходных данных внимания от всех голов они конкатенируются и проходят через заключительное линейное преобразование для генерации выходных данных.

Позиционное кодирование

Поскольку модель Трансформера не является моделью seq2seq и не полагается на последовательность текста для выполнения кодирования и декодирования, в статье использовались синусоидальные и косинусоидальные волновые функции для кодирования позиции токена в эмбеддинг. Методы, представленные в статье, обсуждаются ниже:

где , , соответствуют позиции слова, текущему индексу размерности и размерности модели соответственно. Синусоидальная функция используется для чётных индексов эмбеддинга, а косинусоидальная — для нечётных. Полученный эмбеддинг затем добавляется к слову на соответствующей позиции относительно текущего контекстного окна. В статье особо отмечается, почему был выбран этот метод:

«Мы выбрали синусоидальную версию, потому что она может позволить модели экстраполировать на последовательности длиннее, чем те, которые встречались во время обучения»[1].

Обучение

Хотя основной задачей статьи на тот момент было улучшение машинного перевода, в ней также обсуждалось использование архитектуры для синтаксического анализа по составляющим английского языка как с ограниченными, так и с большими наборами данных. Модель достигла высоких результатов без специальной настройки для этой задачи, что указывало на её перспективность для широкого круга задач seq2seq общего назначения.

Набор данных

Модель для перевода с английского на немецкий обучалась на наборе данных WMT (Workshop on Statistical Machine Translation) 2014 года для пары английский-немецкий, состоящем почти из 4,5 миллионов предложений, взятых из выступлений TED Talks и высококачественных новостных статей. Отдельная модель перевода обучалась на гораздо большем наборе данных WMT 2014 года для пары английский-французский, состоящем из 36 миллионов предложений. Оба набора данных были закодированы с использованием кодирования парами байтов (BPE).

Аппаратное обеспечение

Модели обучались с использованием 8 GPU NVIDIA P100. Базовые модели обучались в течение 100 000 шагов, а большие модели — в течение 300 000 шагов. Каждый шаг занимал около 0,4 секунды для базовых моделей и 1,0 секунды для больших моделей. Обучение базовой модели заняло в общей сложности 12 часов, а большой — 3,5 дня. И базовая, и большая модели превзошли самые современные на тот момент (2017 год) результаты как для англо-немецкого, так и для англо-французского перевода, при этом имея сравнительно наименьшие затраты на обучение[1]. Оценочная стоимость вычислений составила 0,089 петафлопс-дней[14].

Гиперпараметры и регуляризация

Для своей 100-миллионнопараметрической модели Трансформера авторы линейно увеличивали скорость обучения в течение первых 4000 шагов (разогрев), а затем уменьшали её пропорционально обратному квадратному корню от номера текущего шага. Слои исключения (dropout) применялись к выходу каждого подслоя перед нормализацией, к суммам эмбеддингов и к позиционным кодировкам. Коэффициент dropout был установлен на 0,1. Применялось сглаживание меток со значением 0,1, что «улучшает точность и оценку BLEU»[1].

Примечания

Источники

- 1 2 3 4 5 Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia (Dec 2017). Attention is All you Need. In I. Guyon and U. Von Luxburg and S. Bengio and H. Wallach and R. Fergus and S. Vishwanathan and R. Garnett (ed.). 31st Conference on Neural Information Processing Systems (NIPS). Advances in Neural Information Processing Systems. Vol. 30. Curran Associates, Inc. arXiv:1706.03762.

- ↑ Всё, что вам нужно — это внимание (часть 1). Хабр (28 марта 2023). Дата обращения: 30 мая 2025.

- ↑ Love, Julia. AI Researcher Who Helped Write Landmark Paper Is Leaving Google. Bloomberg News (10 июля 2023). Дата обращения: 1 апреля 2024.

- ↑ Goldman, Sharon. 'Attention is All You Need' creators look beyond Transformers for AI at Nvidia GTC: 'The world needs something better'. VentureBeat (20 марта 2024). Дата обращения: 1 апреля 2024.

- ↑ Bahdanau, Dzmitry; Cho, Kyunghyun; Bengio, Yoshua (19 мая 2016). Neural Machine Translation by Jointly Learning to Align and Translate. arXiv:1409.0473 [cs.CL].

- ↑ Shinde, Gitanjali. Data-Centric Artificial Intelligence for Multidisciplinary Applications / Gitanjali Shinde, Namrata Wasatkar, Parikshit Mahalle. — CRC Press, 2024-06-06. — P. 75. — ISBN 9781040031131.

- ↑ Toews, Rob (2023-09-03). Transformers Revolutionized AI. What Will Replace Them?. Forbes. Архивировано 26 сентября 2023. Дата обращения: 2023-12-03.

- ↑ Murgia, Madhumita (2023-07-23). Transformers: the Google scientists who pioneered an AI revolution. Financial Times. Архивировано 28 декабря 2023. Дата обращения: 22 марта 2024.

- 1 2 3 Levy, Steven. 8 Google Employees Invented Modern AI. Here's the Inside Story. Wired (англ.). ISSN 1059-1028. Дата обращения: 20 марта 2024.

- 1 2 Marche, Stephen (23 августа 2024). Was Linguistic A.I. Created by Accident?. The New Yorker (англ.). ISSN 0028-792X. Дата обращения: 24 августа 2024.

- ↑ Meet the $4 Billion AI Superstars That Google Lost. Bloomberg. 2023-07-13 — www.bloomberg.com.

- ↑ Exclusive: the most-cited papers of the twenty-first century. Nature (15 апреля 2025). Дата обращения: 18 апреля 2025.

- ↑ Murgia, Madhumita (23 июля 2023). Transformers: the Google scientists who pioneered an AI revolution. Financial Times. Дата обращения: 22 марта 2025.

- ↑ AI and compute (амер. англ.). openai.com (9 июня 2022). Дата обращения: 29 апреля 2025.

Внешние ссылки

- Uszkoreit, Jakob. Transformer: A Novel Neural Network Architecture for Language Understanding (англ.). research.google (31 августа 2017). Дата обращения: 9 августа 2024. Сопутствующая запись в блоге Google Research.